Đo lường trong phân tích lượng dữ liệu lớn

Quy trình số hóa, đo lường dựa trên máy tính dẫn đến việc gia tăng không ngừng lượng dữ liệu và không gian tham số trong các hệ thống đo lường phân tán, mô phỏng tính toán phức tạp, dữ liệu đa tham số…

Tất cả các phân tích và nghiên cứu đều có điểm chung, việc phân tích dữ liệu để tạo ra tri thức mới, không chỉ đơn thuần là “tìm kiếm” thông tin. BMWi hỗ trợ sáng kiến “Dữ liệu thông minh-Đổi mới dựa trên dữ liệu” (Smart Data – Innovation based on Data) với 30 triệu euro để phát triển các quy trình hiệu quả nhằm thu được dữ liệu có giá trị kinh tế. Với chương trình “Dữ liệu thông minh-Đổi mới từ dữ liệu”, Bộ Kinh tế và Năng lượng Liên bang, Đức đã lựa chọn, tài trợ cho 13 dự án phát triển các dịch vụ sáng tạo.

Việc ứng dụng rộng rãi công nghệ dữ liệu lớn thông minh được bắt ngay từ giai đoạn đầu, mở ra thị trường tương lai cho công nghệ dữ liệu thông minh ở Đức. Đặc biệt, SMEs được hưởng lợi từ các công nghệ này, đặc biệt là về bảo mật dữ liệu và chất lượng dữ liệu. Ấn phẩm “Dữ liệu thông minh-Đổi mới từ dữ liệu” cung cấp cái nhìn tổng quan về các dự án được lựa chọn và giới thiệu các tiêu điểm và mục tiêu của chương trình.

Bên cạnh bảo mật, việc xử lý dữ liệu hiệu quả là nội dung quan trọng của số hóa. Khi doanh nghiệp kết nối với nhau thông qua các phương tiện lưu trữ dữ liệu, cảm biến số, hệ thống truyền dữ liệu sẽ dẫn đến sự gia tăng “theo cấp số nhân” về lượng dữ liệu. Các thuật ngữ mới để nói về dữ liệu như “Dầu của thế kỷ 21” (21st Century’s Oil) hoặc “Đất màu mỡ” (Fertile Soil)…

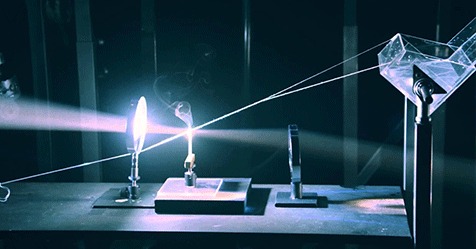

Có thể thấy, phần lớn dữ liệu (trên thực tế là 90%) đã được tạo ra trong hai năm qua. Trong đo lường, các quy trình sử dụng hình ảnh trong y tế, công nghiệp chụp CT hoặc đo bức xạ của các bề mặt phản xạ… dẫn đến hình thành một lượng dữ liệu lớn. Kích thước của đại lượng đo cũng tăng lên tương ứng với phát triển thiết bị.

Ví dụ, máy đo quang near-field của PTB có thể đo quang thông của nguồn sáng với độ phân giải từng phần. Trong trường hợp này, đại lượng đo có tính chất đa chiều. Việc quản lý các thủ tục đo lường đã thiết lập của NQI trước đây sẽ khó thực hiện. Trong bối cảnh này, PTB sẽ có vai trò quyết định năng lực dẫn xuất SI đối với dữ liệu đa chiều được sử dụng cho mô phỏng về hình học của các phần tử truyền ánh sáng.

Nghiên cứu liên ngành tại PTB “mở đường” cho một số dự án chuyên ngành trong các lĩnh vực như: mô hình hóa toán học, phân tích dữ liệu thống kê, xác định độ không đảm bảo đo… thực hiện trong dự án “Mô hình toán học và phân tích dữ liệu” (Mathematical Modelling and Data Analysis).

Do lượng dữ liệu ngày càng tăng, chất lượng dữ liệu, phạm vi các đại lượng đo và phép đo phân tích ngày càng phức tạp, PTB phải đối mặt thách thức đối với việc đánh giá dữ liệu đo lường. Việc xác định độ không đảm bảo đo bị giới hạn về phạm vi và thời gian tính toán. Quy trình số hóa và đo lường dựa trên máy tính dẫn đến việc gia tăng không ngừng lượng dữ liệu và không gian tham số trong các hệ thống đo lường phân tán, mô phỏng tính toán phức tạp, dữ liệu đa tham số…

Mối liên hệ giữa phép đo và việc đánh giá dữ liệu đo ngày càng trở nên phổ biến, được thực hiện dựa trên toán học và thống kê. Việc chuyển đổi hoạt động đo lường đã được thiết lập và chấp nhận sang các các quy trình mới (Ví dụ, phương pháp mô phỏng) với lượng lớn dữ liệu và thời gian tính toán lâu cũng là thách thức lớn.

Các công cụ toán học và thống kê mới được phát triển để giải quyết khó khăn trong việc thực hiện hoạt động đo lường đã được thiết lập, nhằm chuyển đổi dữ liệu thành công.

Bên cạnh đó, việc giảm phạm vi, cấu trúc và lượng dữ liệu những vẫn bảo đảm duy trì thông tin là một yêu cầu cần thiết. Các thông số kỹ thuật về phép đo có vai trò quan trọng để phát triển hoạt động đo lường hiệu quả. Điều này đòi hỏi sự hợp tác nghiên cứu chung giữa dự án “Lập mô hình toán học và phân tích dữ liệu” và các bộ phận thực nghiệm trong PTB. Với sự hỗ trợ của máy tính, các phép đo mới hình thành lượng dữ liệu lớn trong hoạt động kiểm định, hiệu chuẩn.

Ví dụ, trong đo lường bức xạ của một nguồn sáng, một phép đo duy nhất tạo ra giá trị xấp xỉ 100 GB dữ liệu đo lường. Sự mở rộng của hoạt động đo lường cơ bản mà cho phép các phép đo bổ sung, dẫn đến sự gia tăng khác về lượng dữ liệu. Hội đồng Khoa học và Nhân văn Đức cũng cho rằng các phép đo tạo ra lượng lớn dữ liệu đa chiều; tuy nhiên, không phải tất cả các thông tin đều được xử lý. Các nghiên cứu liên quan đến việc phân tích và sử dụng dữ liệu là cần thiết, trở thành nhu cầu quan trọng trong lĩnh vực chuyển đổi số.

Việc phát triển các giải pháp số để làm giảm phạm vi dữ liệu hay phát triển các giải pháp khả thi và tin cậy để truyền một lượng lớn dữ liệu sẽ không có nhiều ý nghĩa. Vấn đề không phải là lưu trữ dữ liệu hay tăng tốc độ truyền dữ liệu, mà việc thiết lập một định dạng dữ liệu chuẩn, phù hợp sẽ có vai trò quan trong.

PTB hợp tác một số nhà sản xuất để phát triển thiết bị đo và các phòng hiệu chuẩn và thử nghiệm để cung cấp các phép đo. Trong trường hợp này, một định dạng dữ liệu thống nhất, chuẩn hóa là cần thiết cho các phép đo. Định dạng dữ liệu này phải có thể bao gồm hình ảnh dữ liệu phức tạp, dữ liệu đa chiều, độ không đảm bảo đo và thông tin thích hợp cho phép phân tích dữ liệu tin cậy.

Việc kết nối dữ liệu với sự hỗ trợ của máy tính sẽ được đảm bảo. Dựa trên hạ tầng hiện có, kinh nghiệm của bộ phận “Hình ảnh và Quang học sóng” (Imaging and Wave Optics) và sự hợp tác với dự án “Mô hình Toán học và Phân tích Dữ liệu”, PTB có thể phát triển các định dạng dữ liệu quang học và phương pháp phân tích đầy đủ nhằm đáp ứng mục tiêu chuyển đổi số trong quang học.

Phương pháp khai thác dữ liệu (Data Mining Methods) là một trong các phương pháp được sử dụng rộng rãi trong các lĩnh vực như phân tích thời gian thực trong cách mạng Công nghiệp 4.0. Qua đó, dữ liệu cảm biến liên tục được đánh giá và so sánh với nhau. Ví dụ về việc phân tích tương quan dữ liệu của các mô-đun quang điện theo chuỗi giá trị. Bằng cách phát triển các phương pháp đo lường và xác định liên kết chuẩn đầy đủ, các quy trình phân tích dữ liệu cho phép thiết lập chỉ số hiệu suất trong sản xuất tấm wafer hoặc cho phép “phản ứng sớm” trong trường hợp xảy ra lỗi. Điều này khẳng định sự cần thiết trong việc kết hợp các kiến thức đo lường và thống kê toán học.

Các nghiên cứu cho thấy lĩnh vực phân tích dữ liệu lớn và dữ liệu tự động (như Học máy và Mạng nơ-ron nhân tạo) ngày càng tăng nhanh. Mạng nơ-ron nhân tạo được lấy cảm hứng từ cấu tạo sinh học của bộ não loài người – sự liên kết giữa các nơ-ron. Tuy nhiên, không giống như một bộ não sinh học nơi mà bất kỳ nơ-ron nào cũng có thể liên kết với các nơ-ron khác trong một khoảng cách vật lý nhất định, các mạng thần kinh nhân tạo này có các lớp rời rạc, các kết nối, và các hướng truyền dữ liệu. Mỗi nơ-ron đảm nhiệm một chức năng – làm thế nào để biết chính xác liệu rằng nó có liên quan đến nhiệm vụ đang được thực hiện.

Vì vậy, suy nghĩ về điểm dừng là một dấu hiệu. Các thuộc tính của một hình ảnh dấu hiệu “dừng” được cắt nhỏ và “kiểm tra” bởi các nơ-ron – dạng hình trụ, màu đỏ của các động cơ cháy, chữ cái đặc trưng, kích thước biển báo giao thông, và sự chuyển động hoặc sự thiếu hụt của nó.

Nhiệm vụ của mạng thần kinh là để kết luận liệu đây có phải dấu hiệu dừng hay không. Nó đi kèm với một “véc-tơ xác suất”. Trong ví dụ trên, hệ thống có thể xác định chắc chắn đến 86% một dấu hiệu dừng, 7% rằng đó là một dấu hiệu giới hạn tốc độ, và 5% còn lại là một con diều bị mắc kẹt trong cây hoặc cái gì đó tương tự,… và kiến trúc mạng sau đó sẽ thông báo đến mạng nơ-ron cho dù đó là đúng hay sai.

Các phương pháp được phát triển hiện nay thường dựa trên lý thuyết đã thiết lập. Những phương pháp này được gọi là phương pháp “Học sâu” (Deep Learning) 1. Do có sẵn các nền tảng phần cứng chuyên dụng cùng với các phần mềm nguồn mở và lượng dữ liệu rất lớn, các phương pháp “Học sâu” đang trở nên quan trọng trong một số lĩnh vực.

Từ quan điểm NQI, đặc biệt là từ quan điểm đo lường, khía cạnh độ tin cậy của các kết quả đo là rất quan trọng. Tuy nhiên, hiện nay, nhiều phân tích dữ liệu như vậy vẫn chưa phù hợp theo hoạt động đo lường. Độ tin cậy của phân tích dữ liệu và các phương pháp để đánh giá định lượng chất lượng của kết quả là chủ đề được Viện Viễn thông Fraunhofer, Viện Heinrich Hertz (HHI) ở Berlin tập trung nghiên cứu.

Trong bối cảnh chuyển đổi số, sự phát triển của các phương pháp xác định độ không bảo đảm đo vẫn còn ở giai đoạn sơ khai. Một hạn chế khác là tính rủi ro đối với các kết quả phân tích dữ liệu nếu dữ liệu đầu vào bị giả mạo.

Hà Minh Hiệp – Đoàn Anh Vũ – Trịnh Phương Linh – Hoàng Ngọc Minh – Nguyễn Thị Ngọc Minh